БЕЗ скриптов, макросов, командной строки и регулярных выражений.

Эта статья понадобится студентам, каковые желают скачать все картины с сайта разом, дабы позже одним перемещением засунуть их в Power Point и сходу взять готовую презентацию. Обладателям электронных библиотек, каковые собирают новые книги по ресурсам соперников. Легко людям, каковые желают сохранить занимательный сайт/страницу в соцсети, опасаясь, что те смогут не так долго осталось ждать провалиться сквозь землю, и менеджерам, собирающим базы контактов для рассылок.

Имеется три главные цели извлечения/сохранения данных с сайта на собственный компьютер:

Дабы не пропали;

Дабы применять чужие картины, видео, музыку, книги в собственных проектах (от школьной презентации до полноценного сайта);

Дабы искать на сайте данные средствами Spotlight, в то время, когда Гугл не осилит (к примеру поиск изображений по exif-данным либо музыки по исполнителю).

Ситуации, в то время, когда нежданно пригодится автоматизированно сохранить какую-ту данные с сайта, смогут произойти с каждым и нужно быть к ним готовым. Если вы можете писать скрипты для работы с утилитами wget/curl, то имеете возможность смело закрывать эту статью. А вдруг нет, то на данный момент вы определите о самых несложных приемах сохранения/извлечения данных с сайтов.

1. Скачиваем сайт полностью для просмотра оффлайн

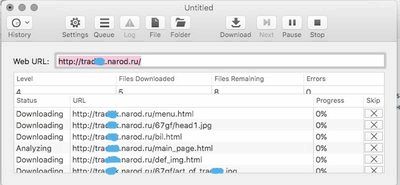

В OS X это возможно сделать посредством приложения SiteSucker. В App Store оно продается за 379 рублей, но на сайте возможно скачать ветхие версии приложения безвозмездно. В примерах использована версия 2.4.6, которой вполне достаточно для исполнения большинства задач. Пользователи Windows смогут применять HTTrack Website Copier, которая настраивается схожим образом.

Пользоваться Site Sucker весьма легко. Открываем программу, выбираем пункт меню File -> New, показываем URL сайта, нажимаем кнопку Download и ждём окончания скачивания.

Дабы взглянуть сайт нужно надавить на кнопку Folder, отыскать в ней файл index.html (основную страницу) и открыть его в браузере.

SiteSucker скачивает лишь те эти, каковые дешёвы по протоколу HTTP. В случае если вас интересуют исходники сайта (к примеру, PHP-скрипты), то для этого вам необходимо в открытую попросить у его разработчика FTP-доступ.

2. Прикидываем какое количество на сайте страниц

Перед тем как браться за скачивание сайта, нужно примерно оценить его размер (не затянется ли процесс на продолжительные часы). Это возможно сделать посредством Гугл. Открываем поисковик и набираем команду site: адрес искомого сайта. Затем нам будет известно количество проиндексированных страниц.

Эта цифра не соответствуют правильному количеству страниц сайта, но она показывает на его порядок (много? тысячи? много тысяч?).

3. Устанавливаем ограничения на скачивание страниц сайта

Если вы поняли, что на сайте тысячи страниц, то возможно сократить число уровней глубины скачивания. К примеру, скачивать лишь те страницы, на каковые имеется ссылка с основной (уровень 2). Кроме этого возможно сократить размер загружаемых файлов, на случай, в случае если обладатель хранит на своем ресурсе tiff-файлы по 200 Мб и дистрибутивы Linux (и такое случается).

Сделать это возможно в Settings -> Limits.

4. Скачиваем с сайта файлы определенного типа

В Settings -> File Types -> Filters возможно указать какие конкретно типы файлов дано скачивать, или какие конкретно типы файлов не разрещаеться скачивать (Allow Specified Filetypes/Disallow Specifies Filetypes). Так возможно извлечь все картины с сайта (или напротив проигнорировать их, дабы места на диске не занимали), и видео, аудио, десятки и архивы других типов файлов (они дешёвы в блоке Custom Types) от документов MS Word до скриптов на Perl.

5. Скачиваем лишь определенные папки

В случае если на сайте имеется книги, чертежи, карты и другие неповторимые и нужные материалы, то они, в большинстве случаев, лежат в отдельном каталоге (его возможно отследить через адресную строчок браузера) и возможно настроить SiteSucker так, дабы скачивать лишь его. Это делается в Settings -> Paths -> Paths to Include. А если вы желаете напротив, запретить скачивание каких-то папок, то их адреса нужно указать в блоке Paths to Exclude

6. Решаем вопрос с кодировкой

Если вы поняли, что скачанные страницы вместо текста содержат кракозябры, в том месте возможно попытаться решить эту проблему, поменяв кодировку в Settings -> Advanced -> General. В случае если неполадки появились с русским сайтом, то вероятнее необходимо указать кодировку Cyrillic Windows. В случае если это не сработает, то попытайтесь отыскать искомую кодировку посредством декодера Лебедева (в него нужно вставлять текст с отображающихся криво веб-страниц).

7. Делаем снимок веб-страницы

Сделать снимок экрана может любой. А понимаете ли как сделать снимок веб-страницы полностью? Один из способов — зайти на web-capture.net и ввести в том месте ссылку на необходимый сайт. Не спешите, для сложных страниц время создания снимка может занимать пара десятков секунд.

Еще это возможно провернуть в Google Chrome, а также в других браузерах посредством дополнения iMacros.

Это может понадобиться для сравнения различных предположений дизайна сайта, запечатления на память долгих эпичных перепалок в комментариях либо в качестве альтернативы методу сохранения сайтов, обрисованного в прошлых шести пунктах.

8. Сохраняем картины лишь с определенной страницы

Идем на owdig.com, показываем нужную ссылку, ожидаем в то время, когда отобразятся все картины и кликаем на оранжевую полосу справа, дабы скачать их в архиве.

9. Извлекаем HEX-коды цветов с сайта

Идем на colorcombos.com и набираем адрес искомой страницы и приобретаем полный перечень цветов, каковые использованы на ней.

10. Извлекаем из текста адреса электронной почты

Предположим, что вам нужно сделать рассылку по сотрудникам компании, а их email-адреса имеется лишь на странице корпоративного сайта и копировать их оттуда в ручную займет лишние 20-30 мин..

В таковой ситуации на помощь приходит сервис emailx.discoveryvip.com. Легко засуньте в том направлении текст и через секунду вы получите перечень всех адресов электронной почты, каковые в нем отысканы.

11. Извлекаем из текста номера телефонов

Идем на convertcsv.com/phone-extractor.htm, копируем в форму текст/html-код, содержащий номера телефонов и нажимаем на кнопку Extract.

А вдруг нужно отфильтровать в тексте заголовки, даты и прочую данные, то к вам на помощь придут регулярные выражения и Sublime Text.

Имеется и другие методы извлечения данных с сайтов. Возможно попросить какую-ту данные конкретно у обладателя ресурса, cохранять части веб-страниц посредством iMacros и парсить сайты посредством Гугл Apps Script.

Еще возможно пойти классическим методом и написать для парсинга bash-скрипт, но статей об этом на iPhones.ru до тех пор пока нет.